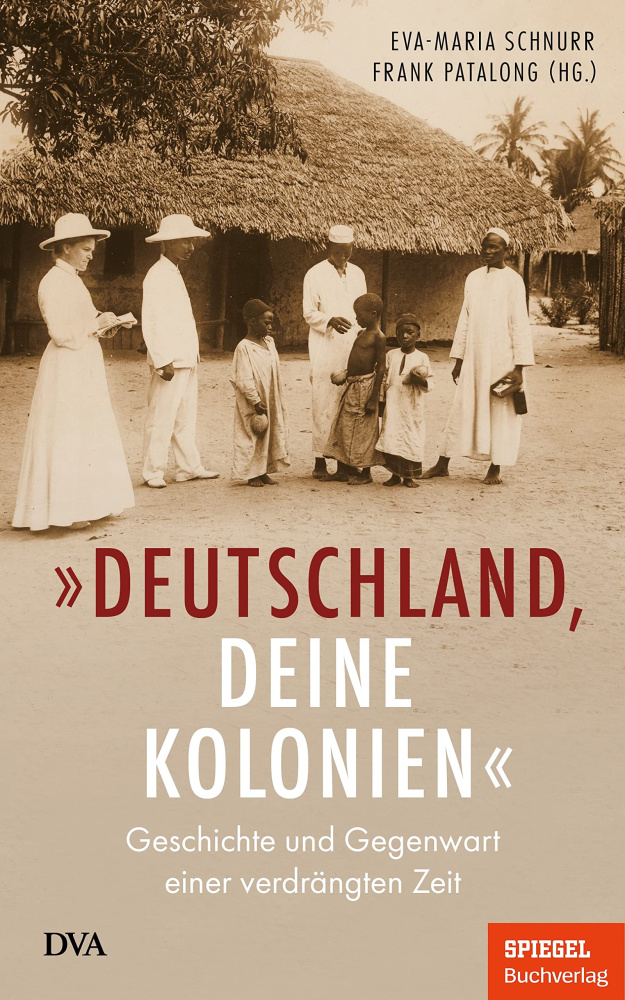

"""Deutschland, deine Kolonien"""

Produktbeschreibung

Das historische Erbe einer verdrängten Zeit

Deutschland war eine Kolonialmacht. Nicht nur in Afrika, sondern auch in China und Ozeanien. Doch in der öffentlichen Debatte wird unsere koloniale Vergangenheit heute kaum diskutiert. Dieses Buch beschreibt Deutschlands einstige Rolle - und warum ihre schlimmen Folgen noch heute zu spüren sind. Es erläutert, warum Rassismus eine entscheidende Grundlage für die koloniale Ausbeutung war, und führt uns die Verbrechen der Deutschen in den Kolonien vor Augen.

Anhand von Zeitzeugenberichten und beispielhaften Schicksalen erfahren wir, was Einheimische nach der Besetzung ihrer Länder erlebten, wie sie von Missionaren behandelt wurden und wie sie sich gegen die Besatzer wehrten. Eine gesellschaftliche Auseidersetzung mit der deutschen Kolonialzeit und ihren Folgen ist überfällig - dieses Buch fordert sie ein.

Weitere beliebte Produkte

Bewertungen

Schreiben Sie als erster eine Rezension

Ihre Meinung interessiert uns – und hilft anderen Kunden bei der Auswahl.